FasterTransformer

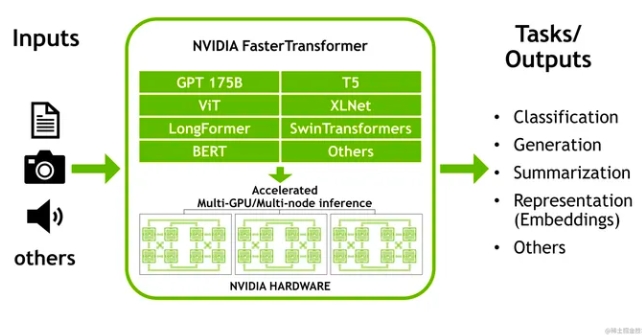

FasterTransformer是NVIDIA开发和维护的一套用于加速基于Transformer的编码器(Encoder)和解码器(Decoder)组件的高优化脚本和方案。由于Transformer模型在自然语言处理(NLP)领域非常流行,尤其是用于处理大规模语言模型(LLM)的推理任务,FasterTransformer提供了一种方式,通过利用NVIDIA GPU的强大计算能力,显著提升处理速度和效率。

FasterTransformer的核心特性包括:

- 高度优化: 在Volta、Turing和Ampere架构的GPU上,可自动使用Tensor Core进行计算,支持FP16精度,大幅提升性能。

- 广泛支持: 快速集成到流行框架中,如TensorFlow、PyTorch和Triton后端,无缝衔接现有的开发流程。

- 支持多种模型和功能: 包含对不同模型的支持,如BERT、GPT、T5等,并支持特性如INT8量化(Turing及更新架构)、稀疏性(Ampere及更新架构)、张量并行和流水线并行等。

使用场景

- 性能至关重要的生产环境: 当面临需要处理大量自然语言处理任务,并且对延迟和吞吐量有严格要求时,FasterTransformer能够提供所需的加速。

- 资源受限的情况: 在资源有限(如限定的GPU内存和计算资源)而需要优化性能以满足业务需求时,FasterTransformer的高效率设计能发挥重要作用。

- 大规模语言模型推理: 对于需要部署大型Transformer模型进行实时推理的应用场景,如聊天机器人、自动翻译、语音识别等,FasterTransformer可以显著缩短响应时间,提升用户体验。

- 研究与实验: 对于研究人员和开发者,FasterTransformer提供的高优化实现和灵活接口,有助于快速实验不同的模型构架和优化策略,推进模型的研究发展。

广告:私人定制视频文本提取,字幕翻译制作等,欢迎联系QQ:1752338621