GPTFast

GPTFast是一种用于加速Hugging Face Transformers模型推理速度的技术,可以让这些模型的执行速度提升大约6到7倍。这个技术最初是为加快Llama-2-7b模型的推理速度而开发的,但现在已经扩展到所有Hugging Face模型上。简单来说,如果你在做与自然语言处理相关的项目,特别是使用Hugging Face的Transformers库,并且追求高效的模型推理速度,使用GPTFast就非常适合。

使用场景

你可能会在以下几种情况下考虑使用GPTFast:

-

在生产环境中部署模型:对于需要实时反馈的应用,如在线聊天机器人、即时文章生成等,加速模型的推理时间是提高用户体验的关键。

-

优化服务器资源使用:加快模型的推理速度可以更高效地利用服务器资源,对于需要处理大量请求的服务来说尤其重要。

-

进行大量模型测试和实验:在研究和开发阶段,有时需要对模型进行大量的实验和测试。在这种情况下,减少每次推理所需的时间可以大大加快实验进程。

使用前提

GPTFast的使用有一定的前提条件:

- Python版本需要3.10或更高。

- 你的设备需要支持CUDA,因为GPTFast利用GPU加速来实现快速推理。

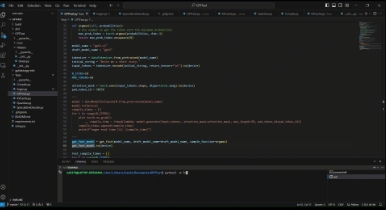

如何使用

使用GPTFast的步骤相对简单:

-

首先,你需要确保你的环境符合使用条件(如Python版本,CUDA支持等)。

-

接着,你需要创建一个Python虚拟环境,并通过pip安装GPTFast。

-

然后,按照GPTFast的文档,编写适用于你的模型的Python代码。代码示例中展示了如何载入模型、设置模型,以及如何执行加速的推理。

-

最后,运行你的脚本,模型的推理时间应该会大大缩短。

如果你在使用Hugging Face的Transformers库,并且希望提升模型推理速度,那么GPTFast是一个非常有用的工具。不管是为了改善最终用户的使用体验,还是为了提升开发和测试的效率,使用GPTFast都能在很大程度上帮助你达到目标。

广告:私人定制视频文本提取,字幕翻译制作等,欢迎联系QQ:1752338621