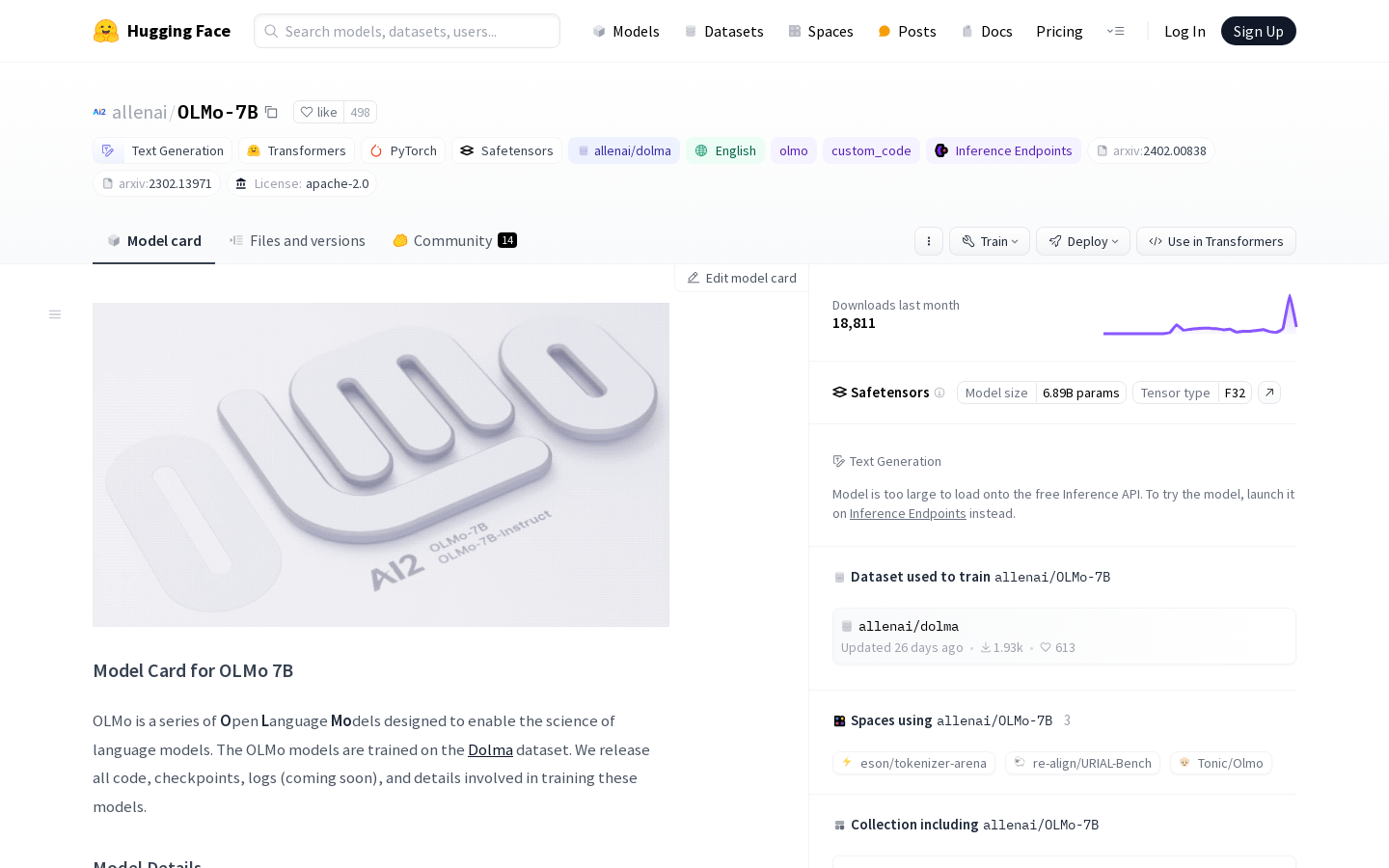

OLMo-7B

OLMo 7B是一系列开放语言模型的核心之一,旨在加速语言模型科学。该模型由Allen Institute for AI (AI2)开发,并由Databricks、哈佛大学Kempner Institute for the Study of Natural and Artificial Intelligence、AMD、CSC(Lumi Supercomputer)、UW提供支持。它是一种Transformer风格的自回归语言模型,使用NLP语言为英语。该模型的训练数据集为Dolma dataset。此外,OLMo 7B是一个大型模型,训练了2.5万亿的tokens,具有32层,隐藏单元大小为4096,具有32个Attention Heads。模型的代码和模型以Apache 2.0许可证发布。

广告:私人定制视频文本提取,字幕翻译制作等,欢迎联系QQ:1752338621