bert.cpp

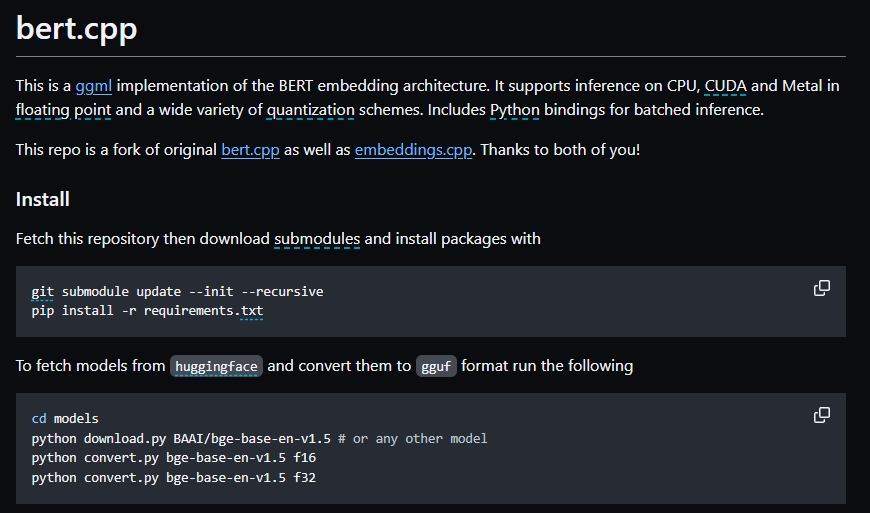

bert.cpp 是一个基于 ggml(一种用于深度学习的小型库)实现的BERT嵌入结构,适用于多种计算平台和数据格式。BERT(Bidirectional Encoder Representations from Transformers)是一种流行的自然语言处理(NLP)预训练模型,用于理解语言的上下文含义。这个项目允许你在不同的硬件上(CPU、CUDA、Metal)和不同的数据格式(浮点数、量化格式)上运行BERT模型。

使用场景及功能:

-

NLP任务: 当你需要在NLP任务(例如文本分类、命名实体识别、问答系统等)中使用预训练的BERT模型进行推理时,

bert.cpp能够帮你快速实现这些功能。 -

跨平台支持: 当你需要在不同的硬件平台(如CPU、NVIDIA的CUDA、苹果的Metal)上运行BERT模型,

bert.cpp提供了跨平台支持,使得NLP模型部署更加灵活。 -

性能与精度: 如果你关注于在资源有限的设备上运行模型的性能和精度,

bert.cpp支持多种量化方案(例如16位浮点、32位浮点、及其他量化级别),可以帮助减少模型大小,加快推理速度,同时尽量保持推理质量。 -

批处理推理: 当需要对大量文本数据进行推理时,

bert.cpp的Python绑定支持批处理操作,提高了数据处理的效率。

具体功能包括:

-

安装:允许你安装所需的Python依赖,并从

huggingface下载预训练模型并转换为ggml支持的格式。 -

构建:提供构建动态库(对于Python使用)的指南,包括针对CPU、CUDA、Metal的特定构建选项,以适配不同的硬件环境。

-

执行:通过命令行或Python脚本运行BERT模型进行文本的推理。

-

量化:支持将模型文件进行量化,以减小模型大小、提高运行效率。

使用示例:

-

当你需要为你的应用程序提供快速且准确的文本理解功能,而且希望这个应用程序能跨不同的设备和平台运行时,

bert.cpp是一个很好的选择。 -

如果你正在开发一个需要处理大量文本数据的项目,并且资源(如存储空间、计算能力)受限,使用

bert.cpp进行模型的量化和批处理推理能显著优化性能。

bert.cpp是BERT模型的一个高效、灵活的实现,适用于各种NLP任务和不同的运算环境,特别适合需要跨平台部署和性能优化的应用场景。

广告:私人定制视频文本提取,字幕翻译制作等,欢迎联系QQ:1752338621