nanoGPT

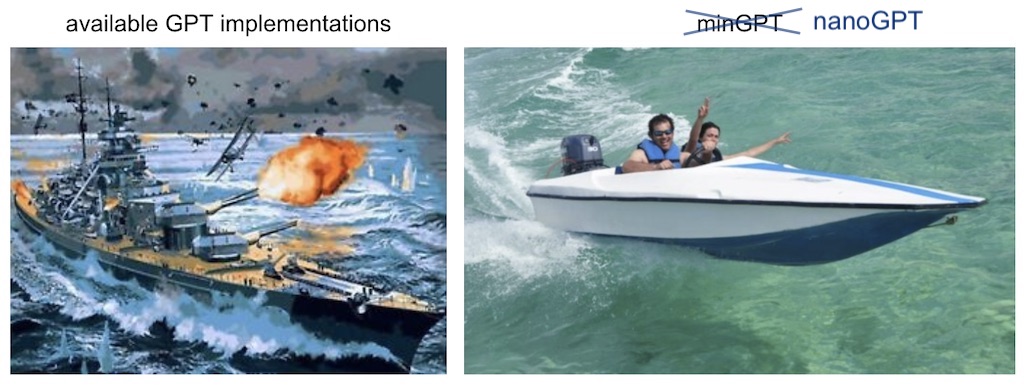

nanoGPT是一个专注于训练或微调中等大小的GPT模型的简洁、高效的工具库。它是基于minGPT进行重写的,目标是使代码更加简洁明了,更便于实际使用而非仅仅作为学习教材。尽管项目仍在积极开发中,但当前版本已经能够在单个8XA100 40GB节点上用大约4天的时间训练出与GPT-2(124M模型大小)相当的模型。nanoGPT的代码非常简单,train.py文件包含了大约300行的训练循环代码,model.py文件则包含了大约300行的GPT模型定义代码,可选支持加载OpenAI的GPT-2权重。

nanoGPT非常易于修改和使用,你可以很轻松地根据自己的需求调整代码,从头开始训练新模型,或者在预训练的模型基础上进行微调。当前可用于微调的最大模型是OpenAI发布的GPT-2 1.3B模型。

安装nanoGPT所需的依赖项非常简单,使用pip安装即可。这些依赖项包括PyTorch、numpy、transformers(用于加载GPT-2检查点)、datasets(用于下载和预处理OpenWebText数据集)、tiktoken(用于OpenAI的快速BPE编码)、wandb(用于可选的日志记录)、以及tqdm(用于进度条显示)。

nanoGPT的一个典型应用场景包括:

-

训练自定义数据集的GPT模型:你可以快速开始训练一个基于特定数据集的GPT模型,例如使用莎士比亚作品进行训练。根据你的硬件配置,可以在几分钟内得到一个初步训练好的模型。这适用于拥有GPU的用户。对于只有CPU的用户,nanoGPT也提供了相应的配置选项,允许在资源较少的环境中进行训练。

-

复现GPT-2结果:对于更有经验的深度学习研究人员,nanoGPT提供了复现GPT-2模型的能力。你可以重现使用OpenWebText数据集训练的GPT-2 (124M)模型。

-

微调预训练模型:nanoGPT也支持在特定数据集上微调预训练好的GPT模型。例如,你可以在小莎士比亚数据集上微调GPT-2模型。

-

文本生成和推理:训练或微调完成的模型可以用于生成文本或进行其他推理任务。nanoGPT提供了简单的脚本来执行这些任务。

无论你是深度学习领域的新手想要尝试训练自己的GPT模型,还是经验丰富的研究人员需要复现或微调GPT-2结果,nanoGPT都是一个值得尝试的工具。借助其简单和易于理解的代码,你可以轻松地调整和实验,推进自己的项目或研究。

广告:私人定制视频文本提取,字幕翻译制作等,欢迎联系QQ:1752338621