VLM Evaluation

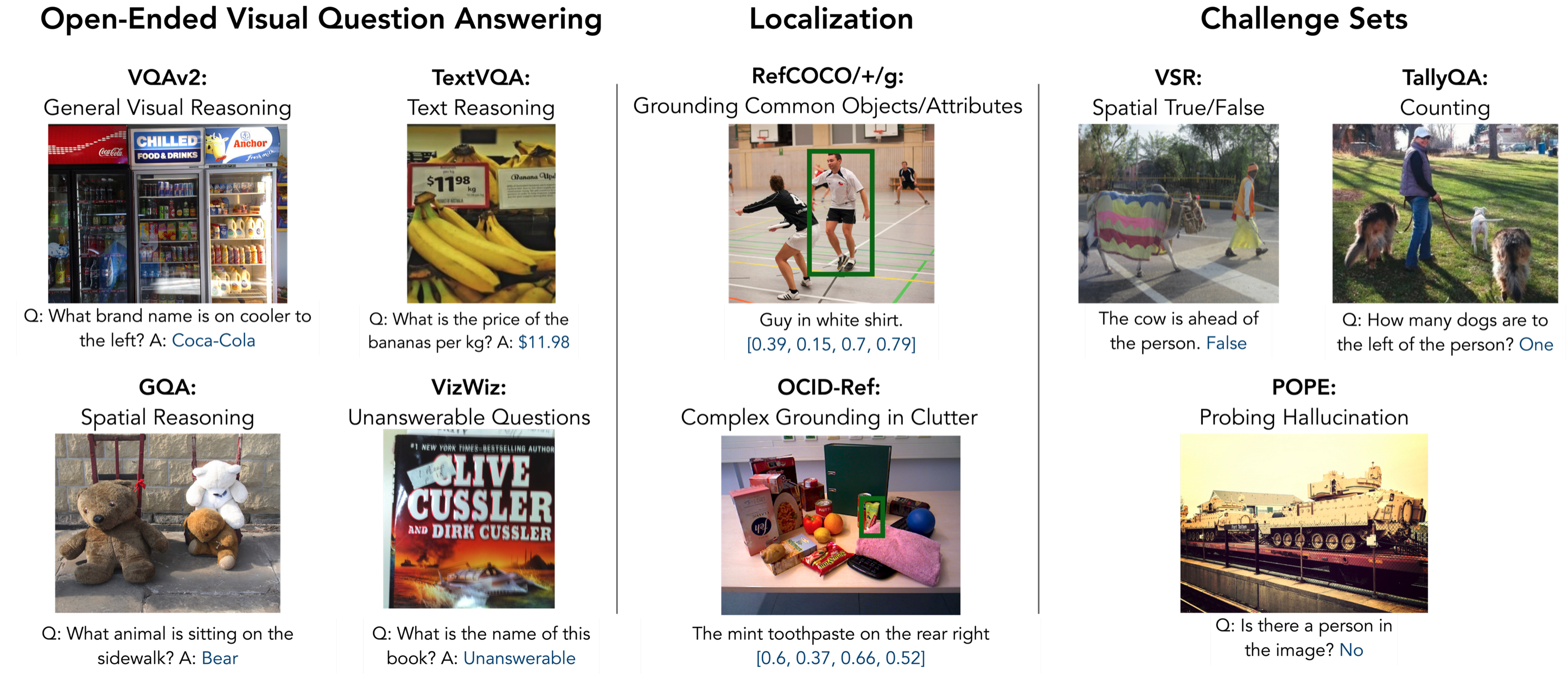

VLM Evaluation 是为视觉语言模型(Visual Language Models,简称VLMs)设计的一个评估基准,覆盖了从视觉问答(VQA)到图像描述生成等多种文本生成任务。这个工具使用了PyTorch框架,并采用了一些优质的代码规范工具,如black、ruff、pre-commit等,以确保代码质量。

何时使用VLM Evaluation

VLM Evaluation 主要用于以下场景:

-

模型评估:当你训练了一个新的视觉语言模型,并希望全面评估其性能时,你可以利用VLM Evaluation提供的任务和评分系统来衡量模型在不同任务上的表现。

-

数据集准备:当你需要为特定的评估任务准备数据集时,VLM Evaluation 提供了脚本来帮助你下载和准备数据集,这可以极大地节约你的时间和精力。

-

交互式GUI演示:如果你希望以更直观的方式展示你的模型效果,VLM Evaluation 提供了基于gradio的交互式GUI演示工具,可以让用户通过简单的图形界面与模型交互。

-

基线模型比较:当你需要将你的模型与市场上其他的模型进行性能比较时,VLM Evaluation 提供的统一的评估框架和任务可以帮助你公平地比较不同模型的性能。

功能概述

VLM Evaluation 的主要功能包括:

-

模型和数据集配置管理:通过配置文件管理不同的模型和数据集,使评估过程更加灵活和自动化。

-

评估脚本:提供了评估脚本来自动执行模型在指定数据集上的评估任务,并生成评估报告。

-

交互式GUI演示:基于gradio的GUI工具,让用户可以通过上传图片和输入问题来实时与模型交亡,并获取模型的输出。

-

评分工具:提供了脚本来计算模型在特定评估任务上的分数,帮助用户更直观地了解模型性能。

-

开发者贡献指南:指导开发者如何为VLM Evaluation 贡献代码,包括代码规范、分支管理、测试等。

无论你是研究人员、开发者还是爱好者,只要你正在研究和开发视觉语言模型,VLM Evaluation 都可以提供一套完整的工具和流程帮助你评估和展示你的模型性能。

广告:私人定制视频文本提取,字幕翻译制作等,欢迎联系QQ:1752338621