Uni-MoE

Uni-MoE 是一个基于 MoE (Mixture of Experts) 框架的统一多模态模型,能够处理包括音频、语音、图像、文本和视频在内的多种模态数据。Uni-MoE 致力于在单一框架内整合和扩展多模态大语言模型 (LLM),利用不同模态的专家模型实现对多模态数据的全面理解和处理。其主要优势在于通过多专家模型的并行处理,显著提高了模型的处理效率和可扩展性。

使用场景

-

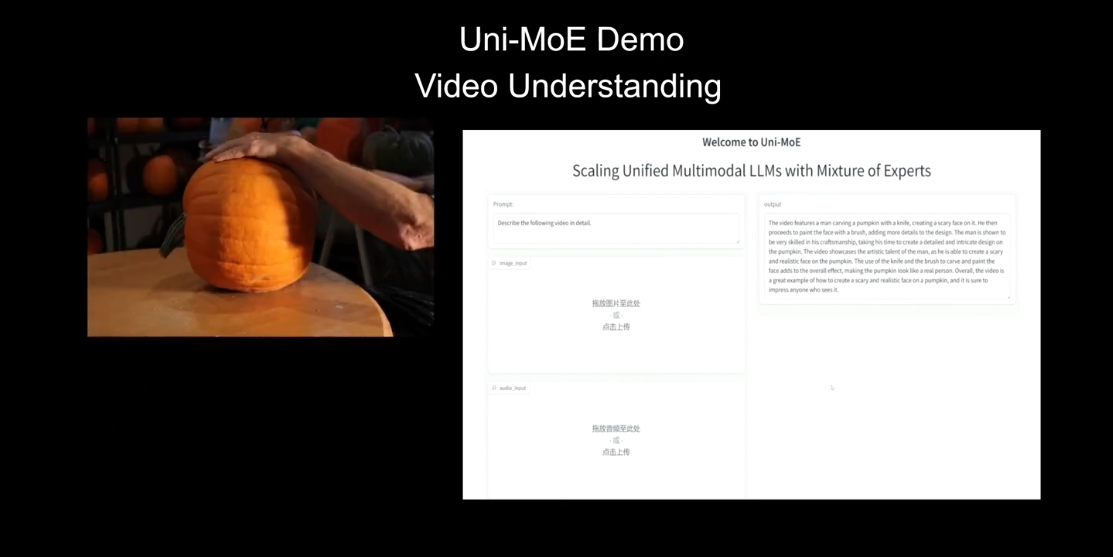

多媒体内容分析与理解:Uni-MoE 能处理图像、视频中的语义内容,用于自动标记、分类、多模态搜索以及相关度分析等任务。

-

语音识别与理解:通过处理语音数据,可以用于语音助理、自动字幕生成、长文本听写等应用场景。

-

音频事件检测和分类:适用于各种音频数据的分析,例如音乐分类、环境音识别等。

-

多模态问答系统:综合文本、图像、音频等数据来源,应用于智能问答系统,提供综合的信息服务。

-

跨模态转换:支持图像生成描述、文本转换为语音、音频生成字幕等任务,实现不同模态之间的转换和融合。

-

视频内容分析与理解:在视频数据中,提取语义信息进行事件检测、视频问答、片段标记等。

主要特点

-

多模态处理能力:Uni-MoE 能够处理多种模态信息,增强了模型的通用性和适应性。

-

高效的专家模型机制:通过引入多个专家模型(例如音频专家、图像专家、文本专家),提升了处理效率和效果。

-

分布式训练:支持跨多节点和多 GPU 的分布式训练,提高了训练速度和模型的扩展能力。

-

模块化设计:允许独立开发和测试不同模态的专家模型,并在最终阶段统一整合,优化了开发和训练流程。

-

多数据集支持:适用于多种标准数据集和实际应用数据,涵盖从基本的图像、音频数据到复杂的多模态数据集。

安装与使用

-

环境配置:建议使用 Python 3.9.16 和 CUDA 11.7 以上的版本。

-

代码克隆与依赖安装:

git clone https://github.com/HITsz-TMG/UMOE-Scaling-Unified-Multimodal-LLMs.git cd UMOE-Scaling-Unified-Multimodal-LLMs/Uni_MoE conda create -n unimoe python==3.9.16 conda activate unimoe pip install -r env.txt -

权重下载与路径配置:将下载的模型权重文件放置在

Uni_MoE/checkpoint目录中,具体权重文件列表和下载链接参照项目文档。 -

推理与展示:

# 推理命令 cd /path/to/Uni_MoE conda activate unimoe python Uni_MoE_audio/inference_all.py python Uni_MoE_speech/inference_all.py -

训练与评估:提供多 GPU 的分布式训练脚本,并支持在多个标准数据集上进行评估,具体使用方法亦详见项目文档。

广告:私人定制视频文本提取,字幕翻译制作等,欢迎联系QQ:1752338621