Farfalle

Farfalle功能概述

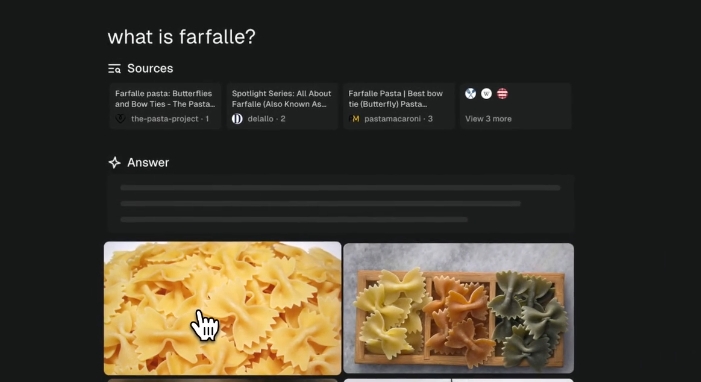

Farfalle 是一个开源的、由人工智能驱动的搜索引擎。这个工具的核心功能是利用本地大型语言模型(LLM)或云端模型来回答问题和进行搜索。

主要功能

- 能够运行本地的LLM,如llama3、gemma、mistral,也支持使用云端模型,如Groq/Llama3、OpenAI/gpt4-o。

- 既可以在本地运行,也可以通过云端进行部署。

适用场景

Farfalle 适用于以下这些情况:

-

快速搜索和问答:当你需要一个高效的搜索工具来快速找到信息或者回答问题时,无论是在本地电脑还是通过云服务。

-

本地模型计算:如果你有高效的本地硬件支持(例如拥有M1 Macbook Pro)并且需要在本地运行大型语言模型,可以使用Farfalle来充分利用本地资源。

-

定制化需求:对于希望根据自己的需求定制搜索引擎功能的开发人员和研究人员,Farfalle提供了开源代码和丰富的配置选项。

-

云端部署与协作:对于需要跨团队协作或者将搜索功能集成到web服务中的情况,可以方便地在云端(如Render、Vercel)进行部署和使用。

如何开始使用Farfalle

前提条件

获取API键

安装步骤

-

克隆仓库

git clone [email protected]:rashadphz/farfalle.git cd farfalle -

配置环境变量 创建

.env文件并添加 API 键:touch .env填入API键,比如:

TAVILY_API_KEY=你的API键 OPENAI_API_KEY=(可选) GROQ_API_KEY=(可选) -

运行Docker容器 确保 Docker Compose 版本为 2.22.0 或更高:

docker-compose -f docker-compose.dev.yaml up -d然后访问 http://localhost:3000 来查看应用。

部署方法

后端

前端

部署前端时使用从Render后端复制的URL,并在Vercel上进行部署:

执行上述步骤后,你就可以开始使用全新的Farfalle搜索引擎了!🥳

广告:私人定制视频文本提取,字幕翻译制作等,欢迎联系QQ:1752338621