Gemma 2B - 10M

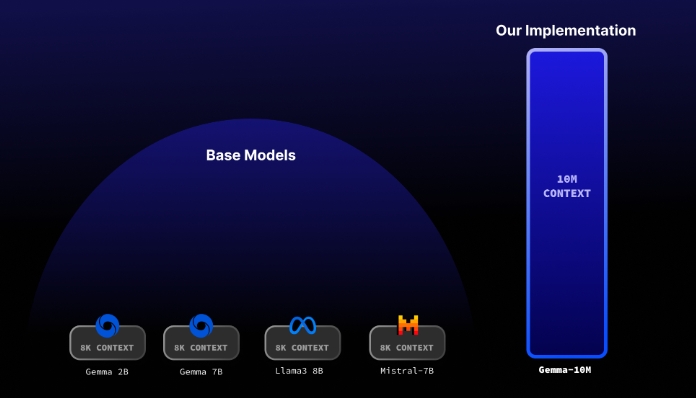

Gemma 2B - 10M是一个基于深度学习的语言模型,旨在处理和生成文本。它的独特之处在于能够处理高达1000万(10M)个字符的序列,而且只需要不到32GB的内存空间。这个模型特别适合需要处理大量文本数据的场景,比如长文章、书籍或者数据密集型的报告等。

传统的语言模型在处理这样长度的文本时会遇到内存瓶颈,因为它们在执行过程中需要保存巨量的中间计算结果。Gemma 2B - 10M通过采用一种称为“重复局部注意力(recurrent local attention)”的技术,有效地解决了这个问题。这种技术分割注意力机制到局部块,并对这些局部块施加重复,从而实现在全局上下文中仅以线性(O(N))的内存增长处理长序列。

使用Gemma 2B -10M的情况

Gemma 2B - 10M非常适合以下几种场景:

- 长篇文本的生成与处理:如小说创作、长篇文章或报告的自动生成。

- 深度文本分析:能够理解和分析大篇幅文本的含义,提取关键信息或总结,这对于研究人员或内容创作者特别有用。

- 数据密集型文本应用:在法律、医学或科研等领域,需要处理大量文献资料时。

如何运行Gemma 2B - 10M

- 安装依赖项:首先,你需要安装模型运行所需的所有依赖。

- 下载并安装模型:通过Huggingface下载Gemma 2B - 10M模型到本地。

- 修改

main.py中的代码:根据你的需求,更改输入提示文本。 - 生成文本:执行脚本,模型将根据你的输入生成文本。

Gemma 2B - 10M采用的技术非常先进,包括但不限于利用CUDA进行优化以加速模型推理过程,以及使用Transformer-XL等模型的灵感。由于这是一个较早的版本,并计划在将来进行更多的训练,因此它的潜力巨大,特别适用于对长文本处理有高要求的应用场景。

广告:私人定制视频文本提取,字幕翻译制作等,欢迎联系QQ:1752338621