llama3 implemented from scratch

详细总结

llama3 implemented from scratch 是一个从零开始实现Llama3自然语言处理模型的项目。这个项目分为以下几个主要功能:

-

加载模型权重:

- 需要从Meta下载官方的模型权重文件。

- 将权重文件加载到Python环境中。

-

分词器(Tokenizer):

- 使用了一个现成的分词器库

tiktoken(可能是OpenAI的开源库)。 - 将输入文本转化为tokens(编码后的文本片段)。

- 使用了一个现成的分词器库

-

读取模型文件:

- 从权重文件中读取每个张量的数据。

-

嵌入层(Embeddings):

- 将tokens转化为其对应的嵌入向量。

- 使用rms normalization对嵌入向量进行归一化处理。

-

Transformer层的实现:

- 包含注意力机制和前馈神经网络部分。

- 注意力机制包括计算查询向量(query)、键向量(key)、值向量(value)、以及通过旋转位置嵌入(RoPE)添加位置信息。

- 计算查询和键的点积来获得注意力得分,并通过softmax进行归一化处理。

- 最终计算得到的注意力向量与值向量相乘,得到更新后的嵌入向量。

-

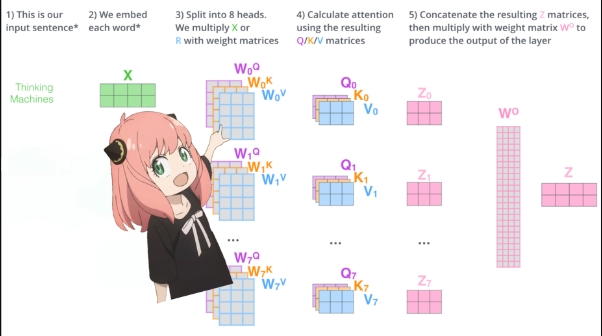

多头注意力(Multi-head Attention):

- 对每个注意力头进行上述计算。

- 合并所有注意力头的结果。

-

前馈神经网络(Feed Forward Network):

- 在得到的注意力向量后,通过SwiGLU激活函数的前馈神经网络进一步处理。

- 更新最终的嵌入向量。

-

最终层和解码:

- 在所有Transformer层计算完成后,进行最后的归一化处理。

- 使用输出权重矩阵将最终的嵌入向量转为输出token。

- 通过解码器解码出下一个预测的token。

最终通过以上过程,从一个给定的提示语中预测下一个token,并验证模型的正确性(在例子中,模型预测了"42"作为下一个token)。

使用场景

以下情况会使用这个项目:

-

教育目的:想了解Transformer模型的原理和实现细节的研究人员或学生。通过从零开始实现,可以深入理解模型的每一步。

-

研究与开发:从事NLP领域研究工作的科学家需要一个可以完全控制和修改的模型来进行实验。

-

模型评估与改进:需要自定义或优化现有模型的开发者。

-

调试和测试:对Llama3模型进行详细的调试、测试或者想要验证一些假设。

-

替代现有库:在某些场景下,现有的深度学习库可能不满足需求,此时从零实现模型能提供更高的灵活性。

通过这个项目,用户能够在更深层次上理解如何实现和使用大型语言模型,并且在特定应用场景下优化性能。

广告:私人定制视频文本提取,字幕翻译制作等,欢迎联系QQ:1752338621