MoA

MoA简介

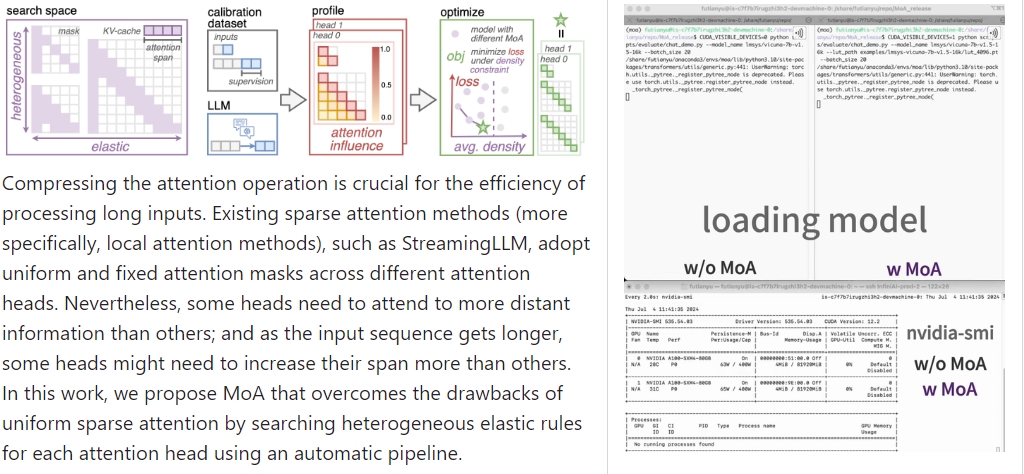

MoA(Mixture of Sparse Attention for Automatic Large Language Model Compression)是一种自动化大型语言模型压缩方法,旨在通过混合稀疏注意机制提升长输入处理效率。传统的稀疏注意方法通常为不同的注意头使用统一且固定的注意掩码,这可能会导致一些注意头需要关注更远的信息,而另一些则不需要。MoA通过一个自动化的流程,为每个注意头搜索异构的灵活规则,从而克服了这种局限性。

使用场景

GPU内存和吞吐量优化

MoA可以将GPU内存消耗减少1.2到1.4倍,并将最大解码吞吐量提高5.5到6.7倍(在7B和13B密集模型上的单个GPU测试中)。因此,MoA特别适用于需要高效解码和受限GPU内存的场景,如实时文本生成和交互。

预定义计划使用

用户可以直接使用已经压缩好的模型配置。在特定的应用中,这些预定义配置能立即带来性能提升,而无需再次执行压缩计划搜索步骤。适用于需要快速部署的场景。

自动搜索流程

对于新的模型或数据集,MoA提供一种自动搜索压缩配置的流程,包括校准数据集生成、梯度分析和注意配置优化等步骤。适用于科研或需要定制模型优化的场景。

长上下文理解能力评估

通过LongBench基准测试,MoA可以评估并保持模型的长上下文理解能力。这些测试有助于验证模型在处理长文本时的性能,适合于长文本分析和处理的应用场景。

检索性能评估

MoA通过评估不同压缩计划在指定输入长度下的检索性能,以确保在减少精度损失的情况下保持原始模型的检索能力。适合作为搜索和信息检索系统的基础模型优化机制。

聊天和实时交互

MoA可以用于优化聊天机器人所用的语言模型,提升其实时交互性能。用户可以通过加载不同长度的压缩计划来与模型进行高效对话。这适用于各种实时聊天应用,如客户服务和智能助手。

MoA为大型语言模型压缩提供了一个自动化、高效且灵活的解决方案,适用于各种需要高效解码和长文本处理的应用场景。

广告:私人定制视频文本提取,字幕翻译制作等,欢迎联系QQ:1752338621