MobileLLM

MobileLLM 简介

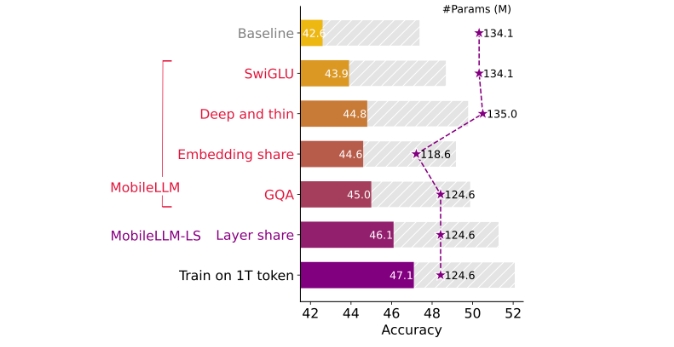

MobileLLM 是一个为设备端应用优化的低参数量大模型(LLM),主要针对参数在十亿以下的模型进行优化。其设计综合考虑了多种因素,以在保持高质量的同时减少参数量。具体来说,MobileLLM 集成了以下技术:

- SwiGLU 激活函数:一种高效的激活函数,提高模型性能。

- 深层且薄的架构:通过增加层数但减少每层的参数量来保持模型能力。

- 嵌入共享:通过共享嵌入层减少参数量。

- 分组查询注意力机制:优化注意力机制,提升计算效率。

在零样本常识推理任务中,MobileLLM-125M 和 MobileLLM-350M 分别相较于前代 125M 和 350M 模型取得了 2.7% 和 4.3% 的准确性提升。实验还证明了这种设计理念能够有效扩展到更大的模型,如 MobileLLM-600M、1B 和 1.5B。

使用场景

MobileLLM 适用于多种需要在设备端直接运行的应用场景,包括但不限于:

- 智能手机和嵌入式设备:在移动设备上运行自然语言处理任务,如语音助手、文本预测和翻译等。

- 物联网设备:如智能家居设备,通过更小的模型实现更智能和高效的交互。

- 边缘计算:在计算资源受限的环境中,如无人机、安防监控等设备上运行智能算法。

这种优化设计不仅在准确性和性能上表现出色,而且通过降低计算复杂度和存储需求,使得大语言模型能够在资源受限的设备上高效运行。

广告:私人定制视频文本提取,字幕翻译制作等,欢迎联系QQ:1752338621