VILA

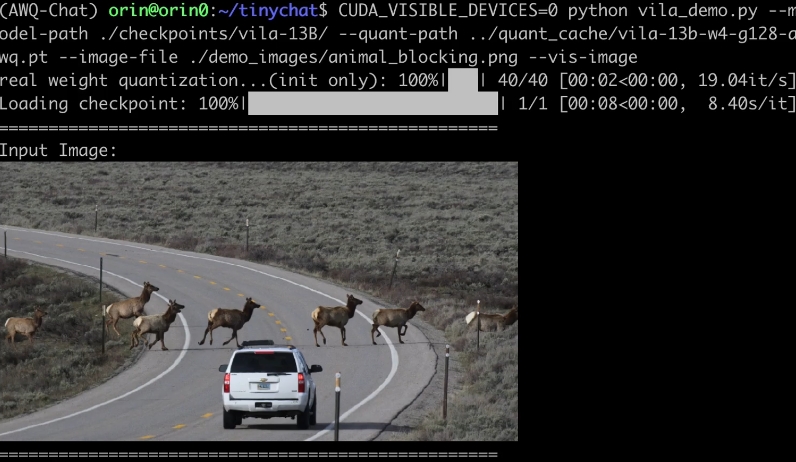

VILA(Visual Language Model)是一种经过大规模图像-文本交替数据预训练的视觉语言模型,具备视频理解和多图像理解的能力。它通过4位量化(AWQ)和TinyChat框架支持边缘设备部署,且在图像与文本的交错预训练中发现了诸多重要特性,比如需要交错图像-文本对而非单一图像-文本对,以及在交错预训练中解冻大语言模型(LLM)以实现上下文学习的能力。

VILA的使用场景

- 视频理解:VILA能够分析和理解视频内容,包括视频中的活动、场景和相关文本信息。

- 图像问答:通过输入图像,VILA可以回答与图像相关的问题,如图像中的物体、场景或活动的详细说明。

- 图像-文本交互:用户可以将图像与文本一起输入,以此来生成更丰富的叙述,或进行更复杂的上下文推理。

- 多图像推理:VILA具备从多幅图像中提取和推理信息的能力,适用于需要综合多个视觉信息源的场景。

- 视频字幕生成:可以生成视频的详细说明或字幕,帮助用户理解视频内容。

VILA的新版本(如VILA1.5)进一步提升了模型的性能,支持更长的视频理解能力,为广泛的应用场景提供了便利。

广告:私人定制视频文本提取,字幕翻译制作等,欢迎联系QQ:1752338621