OLMoE

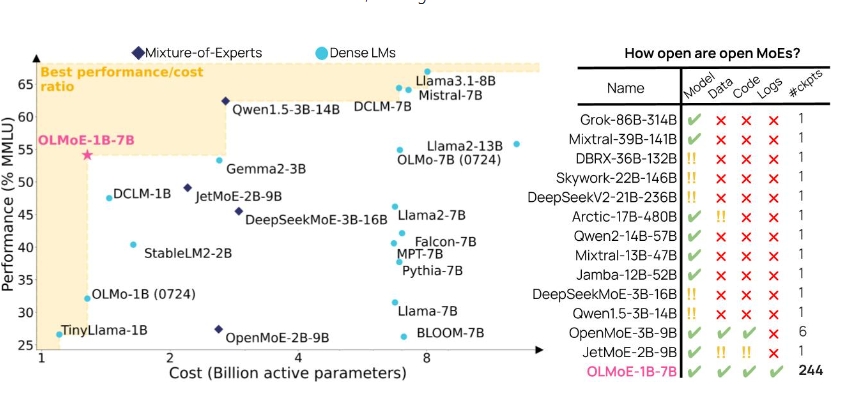

OLMoE(Open Mixture-of-Experts Language Models)是一个完全开放的混合专家语言模型,拥有13亿个活跃参数和69亿个总参数。它代表了当前最先进的技术,并且所有的数据、代码和日志都已公开释放。

OLMoE的特性

- 开放性:所有模型参数、训练数据及代码均可获取,便于研究和应用。

- 灵活性:支持大规模的模型训练和推理,适用于多种自然语言处理任务。

- 效率:通过采用混合专家架构,OLMoE在保持高性能的同时减少了计算资源的消耗。

使用场景

- 文本生成:可以用于生成高质量的文本,如新闻稿、故事等。

- 对话系统:适用于构建智能对话代理,提高用户与机器交互的自然性。

- 文本摘要:能够根据输入的长文本生成简洁的摘要,方便信息提取。

- 语言理解:通过预训练的模型,提升机器对自然语言的理解能力,应用于问答系统等领域。

- 个性化推荐:结合偏好优化(如DPO/KTO),可用于为用户提供个性化的内容推荐。

OLMoE不仅在学术研究中具有广泛的应用潜力,也能够在商业智能、客服、内容创作等领域中发挥重要作用。此次发布为研究人员和开发者提供了一个强大的基础,推动自然语言处理技术的发展。

广告:私人定制视频文本提取,字幕翻译制作等,欢迎联系QQ:1752338621