Byte Latent Transformer

Byte Latent Transformer(字节潜在变换器)简介

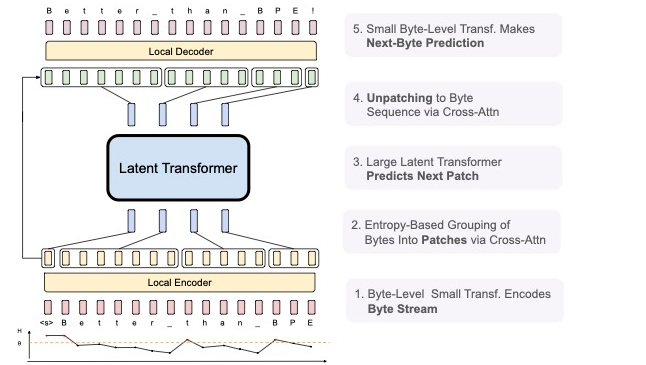

Byte Latent Transformer(BLT)是一种新型的字节级大型语言模型(LLM)架构,首次在大规模上达到了基于标记(tokenization)的LLM的性能,同时在推理效率和鲁棒性上都有显著提升。BLT采用动态大小的字节片段作为计算的基本单位,这些片段根据下一个字节的熵动态分割,使得在数据复杂度较高的地方分配更多的计算和模型能力。BLT架构引入了新的注意力机制,以最大化字节和片段隐藏表示之间的信息流动,并采用了一种新型的字节序列内存。

BLT可从字节端到端进行训练,无需标记化或其他预处理,其首次规模研究显示该模型可扩展至80亿参数和8万亿字节的数据,展现了在推理和推理效率上的优势。同时,由于动态选择较长的片段,BLT在推理时可以更好地进行推理和长尾泛化。

使用场景

-

自然语言处理(NLP):BLT适用于文本生成、文本理解和其他自然语言处理任务,可以处理大规模非结构化文本数据。

-

实时翻译:由于推理效率高,BLT模型可以在实时系统中有效地进行语言翻译。

-

对话系统:在需要快速反应的聊天机器人或对话系统中,BLT可以提供更为准确和流畅的对话体验。

-

代码生成和理解:适用于需要处理编程语言的场景,可以帮助开发者理解和生成代码,提升编程效率。

-

多语言支持:由于其字节级处理的特性,BLT能够处理多种语言文本,具有较强的多语言支持能力。

总之,Byte Latent Transformer通过其创新的字节处理方式和高效的推理能力,打开了大规模语言模型在各个应用场景中的新可能性。

广告:私人定制视频文本提取,字幕翻译制作等,欢迎联系QQ:1752338621