MCP LLM Bridge

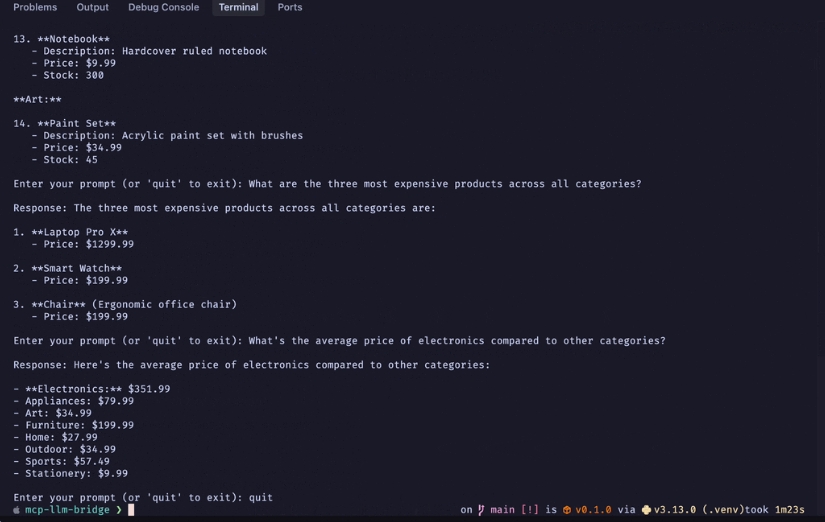

MCP LLM Bridge 是一个连接模型上下文协议(Model Context Protocol, MCP)服务器与兼容OpenAI的语言模型(LLM)的桥接工具。它主要支持OpenAI的API,同时也兼容实现了OpenAI API规范的本地端点。这个实现为MCP与OpenAI的函数调用接口之间提供了双向协议转换层,可以将MCP工具规范转换为OpenAI函数模式,并处理函数调用回到MCP工具执行的映射。这使得任何兼容OpenAI的语言模型都能够通过标准化接口使用符合MCP协议的工具,无论是使用基于云的模型还是本地实现(如Ollama)。

使用场景

MCP LLM Bridge的使用场景包括但不限于:

- 工具集成:通过MCP协议调用和执行各种工具,增强语言模型的功能。

- 多模型兼容:兼容多种语言模型,无论是云端API还是本地模型,便于开发者进行灵活选择。

- 快速实验与测试:开发者可以轻松设置测试数据库并快速尝试不同的查询和操作。

- 研究与开发:支持将MCP协议与多种AI模型相结合的研究,适合开发新型应用或探索AI技术的边界。

通过MCP LLM Bridge,用户能够高效、灵活地利用先进的语言模型和工具,为复杂的AI应用场景提供解决方案。

广告:私人定制视频文本提取,字幕翻译制作等,欢迎联系QQ:1752338621